Was kann Generative KI (GenAI)?

Welche neuen Möglichkeiten eröffnen Large Language Models (LLMs) wie sie in ChatGPT, Microsoft Copilot und anderen Anwendungen zum Einsatz kommen? Wie verändert Generative AI (GenAI) unseren (Arbeits-)Alltag? Diese und weitere Aspekte beleuchten unsere Kolleg:innen im Folgenden: Sie ordnen ein, welche Chancen sich durch ChatGPT & Co im Unternehmenskontext ergeben, wo es (noch) Limitierungen gibt und wie Lösungen dafür aussehen können.

Was ist ChatGPT?

ChatGPT ist ein im November 2022 vom US-amerikanischen Unternehmen OpenAI entwickelter Chatbot. Nutzer:innen können mit diesem Chatbot über textbasierte Nachrichten kommunizieren, um sich bspw. Fragen beantworten zu lassen. Das Besondere daran ist, dass die Antworten mit Hilfe von Machine Learning (ML) generiert werden und wie natürliche Antworten eines Menschen wirken.

GPT steht dabei für „Generative Pretrained Transformer“. Dies ist eine Ausprägung eines Large Language Models, welches OpenAI bereits 2018 entwickelt und seitdem weiterentwickelt hat. Die jeweiligen Versionen werden durch Nummerierung gekennzeichnet, z. B. GPT-4, die Version, auf der die kostenpflichtige Version von ChatGPT aktuell basiert.

GPT-3, GPT-4, GPT-n: Was können neue Versionen?

Im März 2023 – weniger als sechs Monate nach dem Release von ChatGPT auf Basis von GPT-3 – hat OpenAI mit GPT4 bereits eine neue Version ihrer Reihe von Sprachmodellen vorgestellt. Es gab vor allem zwei große Neuerungen:

- Zum einen handelt es sich bei GPT-4 um das erste multimodale Modell der Reihe. Das heißt konkret, dass GPT-4 neben Text auch Bilder als Input verarbeiten kann, beispielsweise zum Beantworten von Fragen zum Inhalt oder auch zum Abgleichen von Bildern und Beschreibungen (potenziell interessant in der Betrugsbekämpfung).

- Zum anderen hat GPT-4 eine deutlich größere Kontextlänge von jetzt bis zu 32.768 Tokens (entspricht rund 25.000 Wörtern). Frühe Transformer-basierte Modelle hatten oft einen Kontext von 256 bis 512 Tokens; eine Länge, die heute von vielen einzelnen ChatGPT-Antworten schnell übertroffen wird. Der größere Kontext von GPT-4 führt dazu, dass es deutlich längere Texte verarbeiten und in einem Chat-Kontext auch weit zurückliegende Antworten noch nutzen sowie automatisch zusammenfassen kann.

Selbst für ein Feld, das sich in den vergangenen Jahren so schnell weiterentwickelt hat wie Künstliche Intelligenz, fühlen sich die Fortschritte im Bereich textverarbeitender, generativer Modelle derzeit rasant an. Es ist daher davon auszugehen, dass in kurzer Zeit weitere Versionen folgen, die noch mehr Features bieten – nicht zuletzt, weil weitere LLM-Lösungen den Wettbewerb erhöhen.

Was ist GenAI?

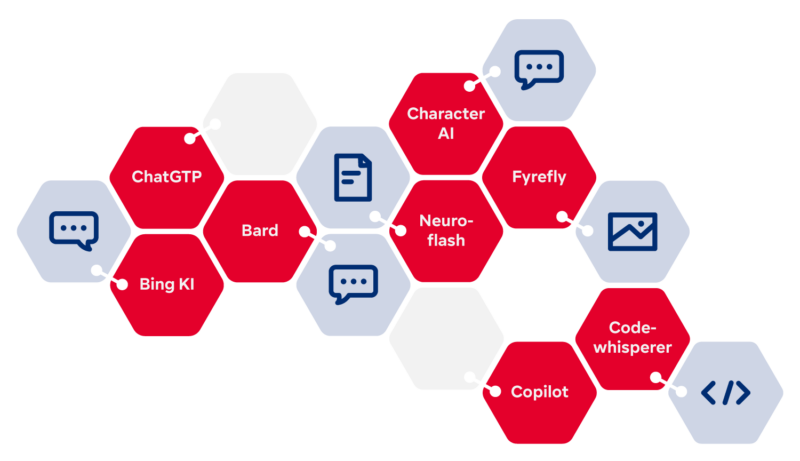

Inzwischen gibt es eine Vielzahl von Lösungen, die auf verschiedenen GPT-Versionen basieren und neben Large Language Models auch Bild, Ton und Video verarbeiten. Während vor einigen Monaten ChatGPT noch als Synonym für diese Lösungen genutzt wurde, findet sich inzwischen vermehrt der Begriff Generative KI bzw. Generative AI oder kurz GenAI. Damit wird dem Faktum Rechnung getragen, dass neben OpenAI viele weitere Anbieter in den Markt eintreten und diese weitaus mehr als Textverarbeitung umfassen.

ChatGPT und andere Generative KI-Lösungen im Vergleich*

Neben ChatGPT gibt es inzwischen zahlreiche weitere Chatbot-Produkte, z. B. von Anbietern wie Amazon, Google oder DeepMind. Zudem finden sich neben textbasierten Produkten auch Tools, die Bilder generieren. Hier einige der aktuell gängigsten im Überblick:

| Name | Anbieter | Funktionen |

| Bard | Textgenerierung & Chatbot | |

| Bing KI | Microsoft | In Bing-Suche integrierter Chatbot |

| Character.ai | Noam Shazeer, Daniel De Freitas | Chatbot mit beliebigen (auch historischen oder fiktiven) Charakteren |

| ChatGPT | OpenAI | Textgenerierung & Chatbot |

| Codewhisperer | Amazon | Vorschläge zur Entwicklung & Vervollständigung von Code |

| Fyrefly | Adobe | Bildgenerierung & z. T. Textgenerierung |

| GitHub Copilot | GitHub, OpenAI | Vorschläge zur Entwicklung & Vervollständigung von Code |

| Luminous | Aleph Alpha | Textgenerierung |

| Microsoft Copilot | Microsoft | KI-Assistentenfunktion für Microsoft 365-Anwendungen wie Word, Excel, PowerPoint & Outlook |

| Midjourney | Midjourney | Bildgenerierung |

| Neuroflash | neuroflash | Deutschsprachiges KI-Content-Tool mit Kombination aus Chatbot, Text- & Bildgenerator, SEO-Tool |

* Da aktuell jeden Monat hunderte neuer Lösungen auf den Markt kommen, erheben wir bei dieser Liste keinen Anspruch auf Vollständigkeit. Sollten Sie Fragen zu bestimmten LLMs haben, kommen Sie gerne auf uns zu.

Einige dieser Produkte sind nur in ausgewählten Ländern, nur für ausgewählte Nutzergruppen oder nur gegen Gebühr verfügbar. Die Funktionen und die Verfügbarkeit ändern sich derzeit jedoch rasant, ebenso wie die Anzahl weiterer vergleichbarer Produkte. Darüber hinaus existieren für viele dieser Produkte inzwischen frei verfügbare Open-Source-Alternativen, die teils sogar auf Endnutzer-Hardware wie Handys oder Laptops lauffähig sind.

Unternehmenseigenes LLM

Sie wünschen sich eine GenAI-Lösung, die Sie unbedenklich in Ihrem Unternehmen einsetzen können und die zugleich hochperformant ist? Mit Alan, dem Comma LLM, das in Deutschland gehostet werden kann, erhalten Sie eine datenschutz- und regulatorik-konforme Technologie, mit der sie GenAI für ihre spezifischen Business-Zwecke einsetzen können.

Vorteile & Limitierungen von ChatGPT im Unternehmenskontext

Textbasierte KI-Modelle können schon seit vielen Jahren sinnvolle Aufgaben in Geschäftsprozessen erledigen. In zahlreichen Kundenprojekten haben wir sie genutzt, um bspw. das Inputmanagement oder die Betrugserkennung bei Versicherern zu optimieren, um frühzeitig Trendthemen bei der Kundenbetreuung zu identifizieren oder um Conversational AI zu ermöglichen. Neben der Chatbot-Funktion, die vielen aus dem Alltag bekannt ist, gibt es bei ChatGPT eine Reihe weiterer Funktionen wie Textklassifikation, Informationsextraktion, maschinelle Übersetzung, automatisierte Textzusammenfassung, Themenmodellierung und vieles mehr. Aufgrund der schieren Menge an Daten, die ChatGPT während seines Trainings „gesehen“ hat, und der Größe des zugrunde liegenden KI-Modells kann ChatGPT viele dieser Aufgaben von Haus aus auf erstaunlich hohem Niveau erledigen. Insbesondere muss es dazu nicht auf extra für die Aufgabe aufwändig gesammelten und vorbereiteten Daten trainiert werden, wie es bei klassischen Machine Learning-Modellen der Fall ist.

Auf dieser Basis könnten Unternehmen viele Routinetätigkeiten von ChatGPT durchführen lassen und – nach menschlicher Qualitätssicherung – die Ergebnisse in Unternehmensprozessen verwenden: von Textvorschlägen für Marketing- und Vertriebsaktivitäten über die Geschäftskorrespondenz bis hin zu Dokumentationen.

Wo ChatGPT an Grenzen stößt

Es stellt sich also die Frage, warum nicht längst alle Unternehmen ChatGPT dafür nutzen. Der Haken ist, dass ChatGPT noch keine unternehmensspezifischen Texte und Informationen kennt. Diese Lücke lässt sich (zum heutigen Zeitpunkt) auch nicht schließen, indem ChatGPT auf diesen Texten nachtrainiert wird. Denn ein solches Anpassen (Transfer Learning) wäre bei ChatGPT aufwändiger als bei bisherigen Modellen, da ChatGPT in Teilen mit der RLHF-Methode (Reinforcement Learning from Human Feedback) trainiert wurde. Hierbei fließt neben reinen Textdaten auch direktes menschliches Feedback in die Entwicklung ein, der Personalaufwand aber auch die Rechenzeiten der Server würden die Kosten deutlich in die Höhe treiben. Bis vor Kurzem war es zudem unverhältnismäßig aufwändig. Dies ist aktuell etwas einfacher geworden, sodass unternehmenseigenes Wissen eingespeist werden kann. Allerdings sind hierbei Datenschutzaspekte zu berücksichtigen (s. ChatGPT vs. Datenschutz & Datensicherheit – Was sollte man bedenken?).

Mit den Limitierungen von ChatGPT umgehen

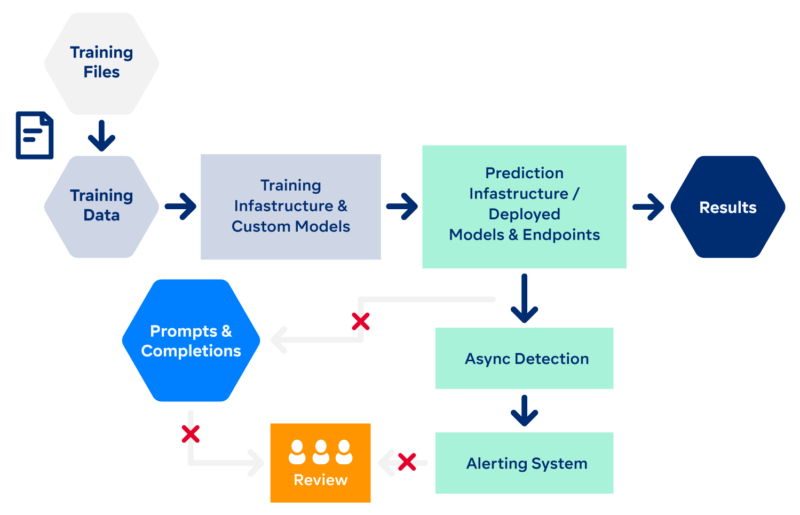

Es gibt Wege, mit diesen Einschränkungen umzugehen. Zum einen besteht natürlich nach wie vor die Möglichkeit, als Unternehmen komplett individuelle KI-Modelle auf eigenen Daten zu trainieren, wo immer diese verfügbar und einfach vorzubereiten sind. Zum anderen können Unternehmen aber auch das Beste aus beiden Welten nutzen, indem sie beispielsweise ein individuell trainiertes KI-Modell dazu nutzen, die eigenen Daten passgenau für eine Anfrage an ChatGPT vorzubereiten. Dies bietet sich zum Beispiel überall da an, wo zunächst relevante Abschnitte aus Dokumenten identifiziert werden müssen, bevor eine konkrete Frage beantwortet werden kann (vgl. dazu auch Microsoft Tech Community). Darüber hinaus gibt es die Möglichkeit, beispielsweise durch Anonymisierung oder Pseudonymisierung automatisiert den Informationsgehalt einer Anfrage an ChatGPT einzuschränken, um so Datenschutz- und Geheimhaltungsbedenken zu begegnen.

Generative AI vs. Datenschutz & -sicherheit – Was sollte man bedenken?

Wer sich mit der Nutzung von GenAI-Modellen wie ChatGPT beschäftigt, kommt unweigerlich auch an den Punkt, sich mit den Datenschutz- und Datensicherheitsaspekten dieser Technologien auseinandersetzen zu müssen. Diese Aspekte lassen sich grob in zwei Bereiche aufteilen:

- Datenschutz bei direktem oder indirektem Trainieren eines KI-Modells

- Datenschutz bei der Nutzung eines „fertigen“ Modells

Direktes Trainieren eines KI-Modells

Beim direkten Trainieren (z. B. bei ChatGPT) geht es um die Frage, ob der Service im Hinblick auf die DSGVO legal ist (oder in den USA geltenden Gesetzen mit ähnlichen Zielen nachkommt; einige Beispiele: Health Insurance Portability and Accountability Act [HIPAA], Children’s Online Privacy Protection Rule [COPPA] oder Kaliforniens California Consumer Privacy Act [CCPA]). Es ist nicht klar, wie z. B. das „Recht auf Vergessenwerden“ (Art. 17 DSGVO) bei einem KI-Modell realisiert werden kann. Eine einmal gelernte Information „verbleibt“ im KI-Modell. Weiterhin gibt es bei ChatGPT auch keine Möglichkeit, herauszufinden, ob Daten eines Unternehmens oder einer Person dort schon gespeichert und enthalten sind; sie dann löschen zu lassen, ist ebenfalls nicht möglich (Art. 15 DSGVO). Weitere kritische Aspekte sind zudem Urheberrechtsfragen: z. B. wurde ChatGPT teilweise auf geschütztem Material trainiert und kann dies wiedergeben. OpenAI hat bisher niemanden für die Nutzung von Daten kompensiert. Unklar ist daher, wie es um die kontextuelle Integrität von Information steht, die ggf. durch ein KI-Modell verletzt werden kann. Diese Aspekte betreffen erst einmal OpenAI als Unternehmen hinter ChatGPT.

Indirektes Trainieren eines KI-Modells

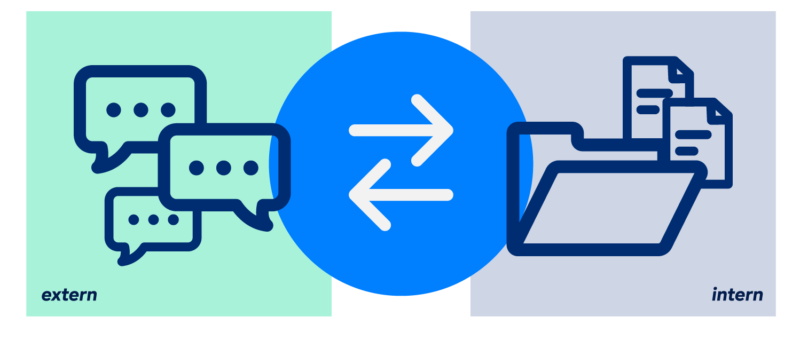

Indirektes Training kann bei der eigentlichen Nutzung von ChatGPT zustande kommen. OpenAI definiert in ihrer Privacy Policy z. B., dass neben den typischen Informationen wie Cookies und Geräteinformationen auch Input und Dateiuploads gesammelt und ausgewertet werden können und vermutlich zur Verbesserung des Services und KI-Modells genutzt werden. Dies kann vielfältige Datenschutz- und Datensicherheitsprobleme mit sich bringen. Einerseits können vom Nutzer personenbezogene Daten hochgeladen werden, die er oder sie so nicht verarbeiten darf. Andererseits können auch nicht personenbezogene Daten wie kritische unternehmensinterne Information oder Intellectual Property betroffen sein. Im schlimmsten Fall werden diese Informationen zur „Verbesserung“ des KI-Modells genutzt und damit de facto öffentlich und schwer bis kaum löschbar.

Nutzung „fertiger“ KI-Modelle

Anders sieht die Situation bei KI-Services aus, bei denen fertige Modelle nur genutzt werden oder optimierte und mit Kundendaten trainierte Modelle auch nur dem Kunden selbst zur Verfügung stehen, also bei einem klar definierten Mandantenmodell. Als Beispiel seien hier die Azure OpenAI Services genannt. Auch hier können Modelle wie ChatGPT (oder bald auch GPT-4) genutzt werden, allerdings mit deutlich mehr Kontrolle für den Kunden. Anfragen und Antworten an KI-Modelle der Azure OpenAI Services werden laut Microsoft nicht zur Verbesserung des Modells genutzt. Stattdessen werden sie nur für bis zu 30 Tage gespeichert. Um Missbrauchsszenarien zu unterbinden, sind zudem bspw. direkte Eingriffe von autorisiertem Kontrollpersonal und/oder Verbesserungen von Content Management Systemen möglich, welche ethisch fragwürdige Nutzungen erkennen und unterbinden. Für stark regulierte Unternehmen oder Use Cases mit besonders schützenswerten personenbezogenen Daten gibt es hier auch eine Opt-out-Möglichkeit (vorausgesetzt, Microsoft stimmt zu), die ein Logging und potenzielles Review von Input unterbindet.

Auch beim Feintuning und Re-Training von Modellen mit eigenen Daten ist deren Schutz gewährleistet. Trainingsdaten können verschlüsselt in Azure Files abgelegt werden. Mit Kundendaten optimierte Modelle stehen dann nur dem Kunden selbst zur Verfügung (authentifiziert und autorisiert, z. B. mittels Azure AD). Über kritische Daten, die sich in einem solchem Modell befinden können, hat der Kunde selbst die Kontrolle. Damit unterscheidet sich der Service nur in wenigen Stellen von anderen Azure und Microsoft 365 Services wie Azure Files, Teams oder SharePoint Online. Die Pflichten bleiben bei all diesen Services gleich: Das Unternehmen ist dafür verantwortlich, welche Daten es dort speichert (z. B. hinsichtlich personenbezogener Daten) und wie es sicherstellt, dass Unternehmensinformationen nicht öffentlich werden.

Grafik in Anlehnung an Microsofts Darstellung zu Data, privacy, and security for Azure OpenAI Service.

Die Sorgfaltspflicht bleibt

Alles in allem bleibt festzuhalten, dass die Sorgfaltspflicht in Bezug auf die Daten beim Umgang mit Cloud-KI-Services mindestens ähnlich hoch ist wie bei allen anderen Arten von Cloud-Services. Im Zweifelsfall sollte immer ein Datenschutzbeauftragter oder eine Rechtsberatung hinzugezogen werden.

ChatGPT & ESG: Wie steht es um den ökologischen Fußabdruck?

Wenn die Chancen und Risiken von Generativer KI wie ChatGPT diskutiert werden, gehört auch das Thema Nachhaltigkeit dazu. Da die Technologie allerdings noch recht neu ist, gibt es kaum verlässliche Studien. Was „sagt“ ChatGPT selbst zu seinem ökologischen Fußabdruck? Hier die Antwort des Chatbots:

Hallo ChatGPT, ich möchte mehr über ChatGPT und Nachhaltigkeit wissen. Zunächst einmal: Welche Themen gilt es dabei zu berücksichtigen?

ChatGPT: Es gibt mehrere Themen, die Sie untersuchen könnten:

- Umweltauswirkungen: KI-Technologien wie ChatGPT benötigen erhebliche Mengen an Energie, um zu laufen. Sie könnten untersuchen, wie KI-Unternehmen daran arbeiten, ihren ökologischen Fußabdruck zu reduzieren und ihre Produkte nachhaltiger zu gestalten.

- Nachhaltigkeitspotenziale: ChatGPT kann Unternehmen und Einzelpersonen dabei helfen, nachhaltigere Entscheidungen zu treffen, indem es z. B. umweltfreundliche Produkte oder Dienstleistungen vorschlägt oder Informationen über nachhaltige Praktiken bereitstellt.

- Ethische Implikationen: Mit der zunehmenden Verbreitung von KI-Technologien ist es wichtig, die ethischen Implikationen zu berücksichtigen. Wie stellen wir sicher, dass KI-Systeme keine bestehenden Vorurteile verstärken oder Entscheidungen treffen, die marginalisierten Gemeinschaften schaden?

Sehr interessante Themen, danke ChatGPT. Bezüglich der Umweltauswirkung: Wie viel Energie wurde denn eigentlich für das Training von ChatGPT verwendet?

ChatGPT: Das Training von ChatGPT-3, der größten Version des Modells, wird auf einen Verbrauch von rund 284 Terawattstunden (TWh) geschätzt. Zum Vergleich: Das entspricht etwa dem Energieverbrauch des gesamten Landes Belgien innerhalb eines Jahres. [Anm. d. Verf.: Hier übertreibt ChatGPT ein wenig. Eine aktuelle Studie (Patterson et al., Carbon Emissions and Large Neural Network Training, 2021) schätzt den Stromverbrauch von GPT-3 auf 1,3 Terawattstunden, was bei ChatGPT nicht um zwei Größenordnungen mehr sein sollte. GPT-4 wird von ChatGPT in dieser Antwort zudem noch nicht berücksichtigt. Da diese Version um das sechsfache größer ist als GPT-3, muss von einem überproportionalen Anstieg des aktuellen Verbrauchs ausgegangen werden.]

Es ist auch wichtig zu bedenken, dass der Energieverbrauch nicht der einzige Faktor ist, der bei der Umweltbilanz von KI zu berücksichtigen ist. Die Materialien, die zur Herstellung von Hardware verwendet werden, die Entsorgung von Elektroschrott und die Kohlenstoffemissionen, die mit Rechenzentren verbunden sind, tragen alle zum Gesamtumweltimpact von KI-Technologien bei.

Wie viele Tonnen Treibhausgase wurden emittiert, um diese Energie bereitzustellen?

ChatGPT: Die geschätzten Treibhausgasemissionen, die mit dem Training von ChatGPT-3 verbunden sind, betragen rund 1,5 Millionen Tonnen CO2e. [Anm. d. Verf.: Hier geht es mit ChatGPT wieder etwas durch. Nach unserem Kenntnisstand sind die Emissionsmengen wohl nicht ganz so drastisch. Laut oben genannter Studie geht man für das Training von GPT-3 von etwa 550 t CO2e aus, immerhin dem 50-fachen der Pro-Kopf-Jahresemission in Deutschland.]

Diese Emissionen variieren jedoch mit einer Vielzahl von Faktoren, einschließlich der Energiemischung des Stromnetzes, in dem das Training stattfindet, und der Effizienz der verwendeten Hardware.

Es ist klar, dass der Energieverbrauch und die damit verbundenen Treibhausgasemissionen des KI-Trainings signifikant sind und bei der Betrachtung des Umwelteinflusses von KI-Technologien berücksichtigt werden sollten. Es werden Anstrengungen unternommen, um die Emissionen zu senken.

Sehr interessant, welche Anstrengungen sind das genau?

ChatGPT: Ein wichtiger Ansatz ist Sparsity, was bedeutet, dass das Modell nur ein Subset der Eingangsdaten benötigt. Das kann z. B. durch Techniken wie Pruning erreicht werden, wodurch weniger wichtige Verbindungen im neuronalen Netz entfernt werden. [Anm. d. Verf.: Dies ist ein sehr wirkungsvoller Ansatz, bei dem es möglich ist, große Mengen an Verbindungen zu kappen und das Modell dadurch deutlich effizienter zu machen. Bei Interesse nehmen Sie hierzu gerne Kontakt mit uns auf.]

Ein anderer Ansatz ist die Verwendung effizienterer Hardware, wie z. B. spezialisierter Chips, die für die jeweilige KI-Anwendung optimiert sind. Diese Chips können so designt werden, dass sie Berechnungen deutlich energie-effizienter durchführen als herkömmliche CPUs oder GPUs.

Zudem können Modelle auch by-design mit weniger Parametern entworfen werden, wodurch der Energieverbrauch gesenkt wird.

Vielen Dank für die Unterhaltung, ChatGPT.

Vorläufiges Fazit zum Thema ESG:

Die Antworten, die ChatGPT selbst liefert, sowie die hinzugenommenen Studienergebnisse beziehen sich vor allem auf das Training und zeichnen hierfür eine eher negative Ökobilanz ab. Offen bleibt, wie es um Betrieb und Nutzung von ChatGPT steht. Ist dies unter den gegebenen Nachhaltigkeitsaspekten vertretbar? Wie ist die Ökobilanz von alternativen Wegen, um an Informationen zu kommen (z. B. Suchmaschinen) und Ideen zu entwickeln? Ließe sich eventuell eine aus der Nachhaltigkeitsperspektive sinnvolle Kombination erzielen, indem LLM hinter Suchanfragen geschaltet werden? Um hier Klarheit zu gewinnen, sind neue Studien nötig, die sich mit diesen Aspekten beschäftigen.

Digtial Workplace mit GenAI: Beispiel Microsoft 365 Copilot

Microsoft hat im März 2023 ein neues Tool angekündigt: Microsoft 365 Copilot. Die Lösung ist eine Kombination aus einem Large Language Model (LLM) und Daten aus der Entwickler-Umgebung Microsoft Graph. Sie soll beim Erstellen von Dokumenten und Präsentationen, beim Lesen und Zusammenfassen von E-Mails, bei der Auswertung von Daten und vielem mehr unterstützen.

KI ist in vielen Microsoft 365-Apps bereits seit einiger Zeit integriert und ermöglicht Mitarbeiter:innen z. B. Folgendes:

- Automatische Antwortauswahl in Teams und Outlook

- Designvorschläge in PowerPoint

- Live-Untertitel in Teams

Mit Microsoft 365 Copilot kommt nun zusätzlich ein LLM in Microsoft 365-Apps wie PowerPoint, Excel, Word, Outlook, Microsoft Teams, Viva und SharePoint und soll weitere Erleichterungen und Hilfestellungen bieten.

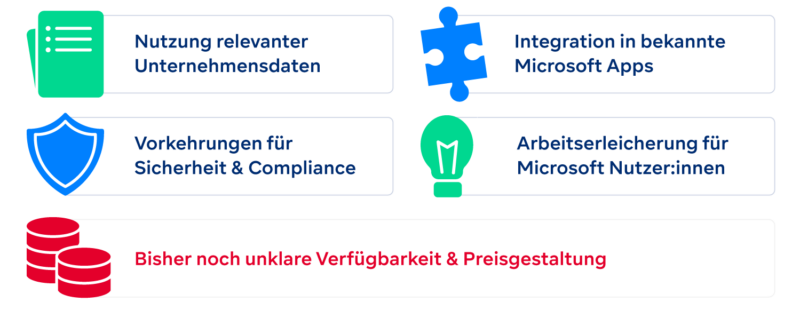

Microsoft Copilot vs. isolierte ChatGPT-Nutzung

Gegenüber den bisherigen KI-Funktionen kommen mit Copilot mehr Möglichkeiten hinzu. Gleichzeitig werden Risiken minimiert, die ChatGPT für Unternehmen birgt.

Nutzung relevanter Unternehmensdaten

Die eigenen Unternehmensdaten und ‑dokumente dienen als Input, sodass die Ergebnisse unternehmensrelevant sind und den Mitarbeiter:innen im Vergleich zu breiten ChatGPT-Ergebnissen bei ihren spezifischen Aufgaben effektiver helfen.

Sicherheit und Datenschutz

Copilot verspricht, den üblichen Sicherheitsstandards von Microsoft zu entsprechen und Security, Compliance und Datenschutz einzuhalten. Das Risiko, dass bspw. Geschäftsgeheimnisse oder personenbezogene Daten außerhalb des Unternehmens verfügbar werden, soll so minimiert werden.

Integration in bekannte Microsoft-Apps

Durch die Erweiterung mit GenAI kann die gesamte App-Funktionalität ausgeschöpft werden. Mitarbeiter:innen müssen dafür nicht mehr einzelne Befehle oder Funktionen kennen, sondern können sie durch die Integration der LLMs mit natürlichen Sprachbefehlen nutzen. Das erleichtert z. B. die Arbeit mit

- Excel: Es ist nicht mehr notwendig, bestimmte Excel-Formeln zu kennen. Copilot soll z. B. bei der Anfrage „Durchschnitt berechnen“ die dafür nötige Formel auswählen.

- PowerPoint: Mitschriften und Notizen sollen sich als Basis für Präsentationen verwenden lassen, die Copilot daraus erstellt.

- SharePoint: Ansprechende Seiten sollen sich viel einfacher mit wenigen Prompts aufbauen lassen.

Wie steht es um die tatsächliche Usability?

Nach und nach soll Copilot in allen Produktivitäts-Apps von Microsoft Einzug halten. Bisher ist die Lösung allerdings nur für wenige ausgewählte Kunden verfügbar und es wurde noch nicht kommuniziert, wann welche Funktionalitäten weiteren Kunden zur Verfügung stehen werden. Auch die Preisgestaltung und die Lizenzkosten sind noch unklar.

Es zeichnet sich ab, dass Microsoft 365 Copilot das Potenzial hat, die digitale Arbeitswelt für Mitarbeiter:innen zugänglicher zu machen – unabhängig von ihrem Wissensstand, ihrer Erfahrung oder auch von Beeinträchtigungen. Statt die Bedienung von Software vollumfänglich erlernen zu müssen, könnten nur noch natürlichsprachlich formulierte Anforderungen nötig sein. Dies scheint eine sehr erfolgsversprechende Ergänzung zu sein, mit der Mitarbeiter:innen Zeit und Schulungsaufwand sparen und sich stattdessen mehr auf inhaltliche Fragestellungen konzentrieren können.

Wann es flächendeckend so weit ist und wie die neuen Funktionalitäten in der Praxis angenommen werden, bleibt weiterhin zu beobachten. Die Zukunft wird auch zeigen, ob Copilot die Office-Welt revolutioniert oder ein Nachfolger des Office-Assistenten Karl Klammer wird.

GenAI jenseits der Wissensarbeit: Beispiel Medizin & Gesundheitswesen

Wie ChatGPT und andere GenAI-Lösungen die Arbeit von Textern, Designer, Software-Entwicklern und anderen Wissensarbeitern unterstützen können, wird vielfach diskutiert. Wie sieht es aber in Bereichen aus, in denen Mitarbeiter:innen nicht ausschließlich am Schreibtisch sitzen, z. B. im Gesundheitswesen?

Auf der Fachkonferenz DMEA 2023 gab Karl Lauterbach seine Einschätzung zum Einsatz von großen Sprachmodellen in der Medizin: Laut dem Gesundheitsminister ist die Anfang März 2023 vorgestellte Digitalisierungsstrategie einen Monat später bereits wieder überholt, weil die Entwicklungen mit Large Language Models (LLMs) dermaßen schnell voranschreiten.

Dass das deutsche Gesundheitswesen auf diese Entwicklungen nur langsam reagieren kann, ist nachvollziehbar. Gründe dafür finden sich u. a. in der Komplexität (von Akteuren über Regulatorik bis zur Tech-Infrastruktur) und den im internationalen Vergleich geringen Forschungsinvestitionen in KI in Deutschland.

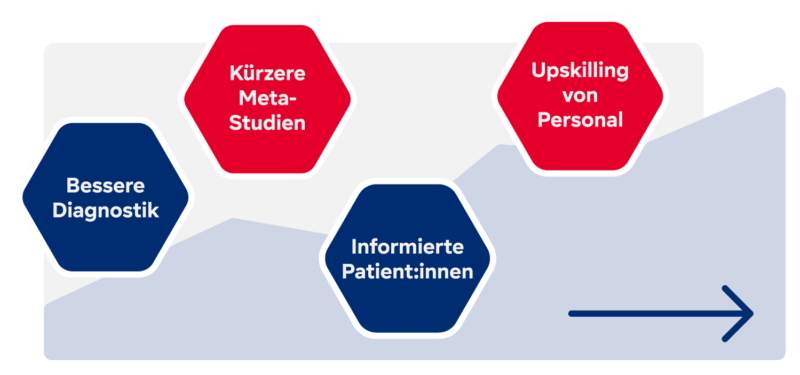

Nichtsdestotrotz: Die Anwendungsmöglichkeiten von LLMs wie ChatGPT in Medizin und Gesundheitswesen sind vielfältig. Auch der Minister äußerte sich auf der DMEA davon überzeugt, dass sie die Medizin nachhaltig und grundlegend verändern werden – und zwar signifikant mehr als bisher bekannte KI-Modelle mit spezifischen Fähigkeiten, z. B. im Bereich Diagnostik oder in der medizinischen Bildgebung.

Beispiele, wie LLMs Medizin & Gesundheitswesen verändern könnten:

- Meta-Studien: „Es gibt keinen Grund zu der Annahme, dass die Modelle eine Metastudie von publizierten medizinischen Studien nicht besser durchführen könnten als Menschen“, so Karl Lauterbach auf der DMEA. Im Gegenteil: Angesichts des großen Wissensspeichers könnten LLMs zusammenführende Studien sogar bald deutlich besser durchführen. Diese neue semantische Komponente kann Meta-Studien auf ein qualitativ neues Level führen und die Entwicklung von Medikamenten und Therapien beschleunigen.

- Empowered Patient: ChatGPT kann Nutzer:innen im Handumdrehen mit Fachwissen versorgen, welches leicht zugänglich aufbereitet werden kann. So schlägt KI eine Brücke zwischen Expert:innen und der Bevölkerung. Medizinisches Wissen kann damit zugänglicher und der sog. „Empowered Patient“ Realität werden.

- Fachkräftemangel: Prof. Dr. med. Klemens Budde von der Berliner Charité ergänzt in seinem Vortrag auf der DMEA, dass ChatGPT vor allem bei jüngeren Ärzt:innen zu besseren Befundungsergebnissen führe, Chefärzt:innen nehmen die Unterstützung dagegen weniger gerne an. Sie kritisieren u. a., dass durch ChatGPT nicht genutzte Fähigkeiten verloren gehen könnten. Allerdings sieht Budde auch die Chance des Upskillings: Ähnlich wie beim Empowered Patient werde Wissen auch außerhalb von Gruppen mit speziellem Fachwissen verfügbar gemacht, was eine Lösung für den Fachkräftemangel im Gesundheitswesen darstellen könnte.

Wann ist GenAI bereit für den Einsatz im Health-Sektor?

Stand jetzt ist die Nutzung von GenAI noch längst nicht selbstverständlich. GenAI Literacy – analog zu Digital Literacy – fehlt bislang der breiten Masse, aber auch in Fachkreisen. Das umfasst neben Skills wie Prompt Engineering auch eine reflektierte Nutzung der Ergebnisse sowie Verständnis für deren Zustandekommen.

Das Vertrauen in Generative KI und ChatGPT sowie die ethischen Aspekte in der Ergebnisgenerierung und Nutzung werfen auch die Frage nach dem Datenschutz auf. Vor allem im Health-Sektor handelt es sich oftmals um sensible Daten, deren Schutz bei der Verarbeitung durch GenAI zunächst sichergestellt werden muss.

Bevor über elaborierte KI-Lösungen gesprochen werden kann, steht das Gesundheitswesen in Deutschland vor der Herausforderung der Modernisierung von Telematik- & IT-Infrastruktur, der Ablösung von Altsystemen und der zielführenden Vernetzung von Einrichtungen. Ohne diese solide Basis sind KI- & datengetriebene Lösungen nicht operativ umsetzbar.

Was Sie in Ihrem Unternehmen jetzt tun können

Generative KI hat das Potenzial, unseren Alltag und die Arbeitswelt grundlegend zu verändern. Mit der obigen Einordnung hoffen wir, Ihnen eine Orientierung hinsichtlich der Möglichkeiten und Grenzen dieser Technologie geben zu können.

Wenn Sie daran interessiert sind, LLMs und verwandte KI-Technologien in Ihrem Unternehmen in Wirkung zu bringen, empfehlen wir Ihnen vor dem Start einen Ideation-Workshop. In diesem ermitteln wir gemeinsam, wie und an welchen Stellen GenAI Ihnen in Ihrem operativen Alltag konkret helfen kann. Leitfragen dafür sind z. B.:

- Welche Prozesse gibt es, die heute hohe manuelle Aufwände verursachen?

- Wo scheitert eine höhere Automatisierungsquote an zu niedriger Datenqualität?

- In welchen Prozessen müssen strukturierte Informationen aus Texten (z. B. E-Mails) extrahiert werden?

- Wo wird KI-Unterstützung bei der Verarbeitung von Bild-, Audio- oder Video-Material benötigt?

- Wann & wo würden Mitarbeiter:innen von schneller & leichter auffindbaren Informationen profitieren?

- Wo kann KI entlasten, indem für Einzelaufgaben Vorschläge geliefert & nur noch verifizieren werden?

- Welche Prozesse würden effizienter ablaufen, wenn sich Menschen nur noch die wirklich relevanten Fälle anschauen müssten?

Weitere Möglichkeiten, was Sie in Ihrem Unternehmen jetzt tun können, finden Sie hier:

Welche Erfahrungen haben Sie bereits mit ChatGPT gemacht? Wo sehen Sie Chancen und wo Herausforderungen für die Nutzung in Ihrem Unternehmen? Diskutieren Sie mit unserer uns darüber: Hier können Sie Kontakt mit uns aufnehmen.

Wir freuen uns auf den Austausch mit Ihnen und begleiten Sie auf Wunsch auch bei der konkreten Umsetzung!