Reisebericht #02

Unsere Humboldt-Redaktionsgruppe ist wieder unterwegs und berichtet Ihnen dieses Mal:

- Wie die aufregende Reise zu ALAN, unserer eigenen Generativen KI verlief.

- Warum angesichts neuer Cyber-Security-Risiken die Devise Zero Trust lauten sollte.

- Welche Bedeutung den Petersberger Gesprächen als Salon der Wirtschaft, Technologie & Wissenschaft zukommt.

- Was unserer Crew-Mitglieder im Rahmen ihrer Arbeit bei Comma Soft und darüber hinaus bewegt.

Viel Spaß beim Lesen und Entdecken!

Wenn Sie über diesen Reisebericht hinaus an Informationen über unsere GenAI- und Cyber-Security-Lösungen interessiert sind, finden Sie auf dieser Seite weitere spannende Informationen. Viel Spaß beim Entdecken!

Wir laden Sie zudem herzlich ein mit uns in Kontakt zu treten: Für Fragen, Anregungen, zum Austausch – schreiben Sie uns und wir melden uns bei Ihnen: fragen@humboldt-gruppe.com

Large Language Models

Large Language Model – LLM – Generative KI – Prompting: Die Terminologie kann verwirrend sein. Wer tiefer in das Thema eintauchen möchte, findet hier weitere Details zu den wichtigsten Begriffen.

GenAI-Glossar

-

-

Jede Form von maschineller Intelligenz wird als Künstliche Intelligenz (KI) bezeichnet. Im allgemeinen Sprachgebrauch wird der Begriff Künstliche Intelligenz verwendet, wenn eine Maschine „kognitive“ Leistungen wie Lernen und Problemlösen nachahmt, die sonst mit menschlicher Denkleistung assoziiert werden. KI ist ein Forschungsbereich der Informatik, in dem intelligente Maschinen entwickelt und studiert werden. Ein wichtiger Bereich der modernen Forschung zur Künstlichen Intelligenz ist maschinelles Lernen (Machine Learning): Dabei lernt die Maschine mithilfe von riesigen Datenmengen, Bilder zu klassifizieren oder Zeitreihen vorherzusagen.

Meet ALAN!

Sie wollen ALAN kennenlernen? Dr. Andrej Fischer und Michael Tannenbaum zeigen Ihnen unser LLM gerne in einer persönlichen Live-Demo. Hier finden Sie weitere Informationen und die Möglichkeit, Ihren Demo-Termin zu buchen.

Weitere Lese-Tipps für Sie

Wir alle sind immer daran interessiert, uns über technologische und ML-/LLM-Trends auf dem Laufen zu halten. Wenn Sie auch tiefer eintauchen wollen, empfehlen wir Ihnen dafür folgende Literatur:

- „Attention Is All You Need“

Dieses Paper ist der Ausgangspunkt für die moderne Entwicklung von LLMs. Es stellt die Transformer-Architektur vor und ist ein Muss für alle, die sich für die technischen Grundlagen von LLMs interessiert.

- „We have no moat and neither does OpenAI”

Leak von einem Google-Researcher, zur erwarteten Überlegenheit von Open-Source-Sprachmodellen.

- „Eagle 7B : Soaring past Transformers with 1 Trillion Tokens Across 100+ Languages (RWKV-v5)”

Veröffentlichung des Eagle-7B-Modells, einem vielversprechenden Sprachmodell, das ohne Attention-Mechanismus auskommt.

- Open Source-Modelle im Vergleich

Wenn Sie einen Überblick über die aktuell verfügbaren Open Source-Modelle suchen, werden Sie hier fündig.

- Petersberger Thesen zu KI

Ein spannendes Format, dass den gesellschaftlichen Impact von Künstlicher Intelligenz lange vor dem Aufkommen von Generativer KI diskutierte.

Zero Trust

Zero Trust ist der heute notwendige Security-Ansatz, den wir mit unseren Kunden im Mittelstand sowie in Konzernen umsetzen. Im Whitepaper gibt Dr. Jan Ciupka noch tiefere Einblicke in das Konzept und dessen Architektur. Auch einen klassischen Angriffs-Fall, das sogenannte Data-Poisoning, haben wir hier für Sie durchgespielt. Daneben finden Sie eine Check-Liste, mit der Sie prüfen können, was in Sachen Cyber-Security die nächsten Schritte für Ihr Unternehmen sein können.

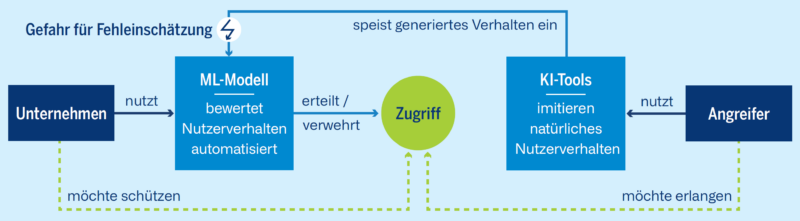

Data-Poisoning

Wie Sie anhand der Abbildung nachvollziehen können, beginnt der Angriff beim Data-Poisoning bereits schon bei den vom ML-Modell verwendeten Daten. Wenn ein ML-Modell bspw. mit Open-Source-Daten trainiert wird, könnten Angreifer diese Daten manipulieren. So kann die KI schadhaft trainiert werden, wenn sie nicht mehr wahrhaftige Daten verwendet, sondern jene, die die KI bewusst auf eine falsche Fährte bringen. Data Poisoning ist ein hoher Kostenfaktor für betroffene Unternehmen, die in das Training ihrer ML-Modelle investiert haben. Es kann zudem auch Einfallstor für den Zugriff von Hackern sein, die sich diesen durch die gezielte Manipulation verschaffen. Die möglichen Folgen für Unternehmen sind bekannt. Verhindert werden kann Data-Poisoning vor allem durch die richtige Cyber-Security-Strategie.

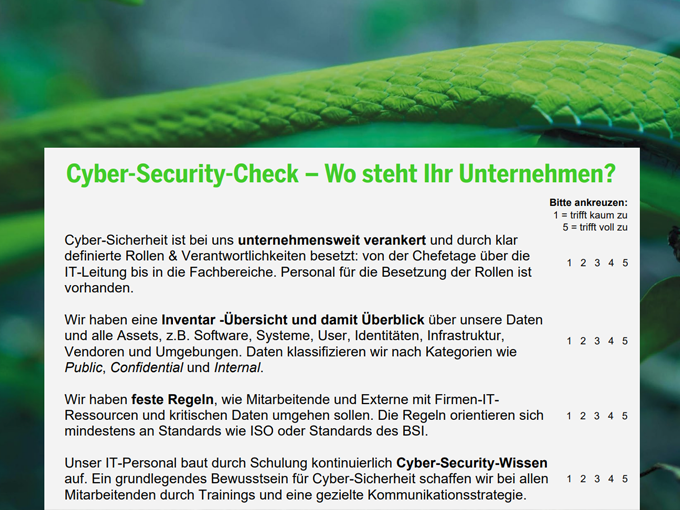

Machen Sie den Cyber-Security-Check!

Sie wollen überprüfen, wie sicher Ihr Unternehmen aufgestellt ist? Diese Checkliste hilft Ihnen dabei, Risiken zu identifizieren und Maßnahmen abzuleiten.

Was heißt Zero Trust denn eigentlich genau?

Unser Kollege Dr. Jan Ciupka hat für Sie in diesem Whitepaper zusammengestellt, was die Grundpfeiler von Zero Trust sind und was unternehmen bei der Umsetzung beachten sollten.

Deep-Dive mit Siemens: Chancen & Challenges von Zero Trust

Siemens setzt bei IT- & Cyber-Security als eines der ersten Unternehmen auf einen Zero Trust-Ansatz. Welche Chancen ergeben sich daraus für die Sicherheit des Konzerns und für die Weiterentwicklung seiner Produkte?

Petersberger Gespräche 2023 – Der Salon für Wirtschaft, Wissenschaft & Technologie

Klicken Sie sich hier durch das Rückblick-Video sowie alle Vorträge und Interviews der Speaker der Petersberger Gespräche 2023:

Wenn Sie wissen möchten, welche Themen und Speaker in der Vergangenheit das Programm gestaltet haben, schauen Sie mal auf dem YouTube-Kanal des Dialogforums vorbei.

KI-Playlist

Sie möchten (Gen)AI selbst auszuprobieren? Vereinbaren Sie bei Interesse gerne eine Demo für Alan mit uns. Daneben haben wir Ihnen hier eine Hitliste spannender KI-Anwendungen zum Ausprobieren zusammengestellt. Viel Spaß!

Die Reise geht Weiter!

Wir sind bereits wieder in See gestochen und erkunden weiterhin neue Welten.

Sie möchten ein weiteres Exemplar des aktuellen Berichts oder möchten sich und Ihre Kolleg:innen für die nächste Ausgabe vormerken lassen? Schreiben Sie uns!